(12주차) 5월18일

import tensorflow as tf

import tensorflow.experimental.numpy as tnp

import numpy as np

import matplotlib.pyplot as plt

tnp.experimental_enable_numpy_behavior()

- 데이터생성 (그냥 흑백대비 데이터)

_X1 = tnp.ones([50,25])*10

_X1

_X2 = tnp.zeros([50,25])*10

_X2

tf.concat([_X1,_X2],axis=1)

_noise = tnp.random.randn(50*50).reshape(50,50)

_noise

XXX = tf.concat([_X1,_X2],axis=1) + _noise

XXX=XXX.reshape(1,50,50,1)

plt.imshow(XXX.reshape(50,50),cmap='gray')

- conv layer 생성

conv = tf.keras.layers.Conv2D(2,(2,2))

conv.weights # 처음에는 가중치가 없음

conv(XXX) # 가중치를 만들기 위해서 XXX를 conv에 한번 통과시킴

conv.weights # 이제 가중치가 생김

- 가중치의 값을 확인해보자.

conv.weights[0] # kernel에 해당하는것

conv.weights[1] # bias에 해당하는것

- 필터값을 원하는 것으로 변경해보자.

w0 = [[0.25,0.25],[0.25,0.25]] # 잡티를 제거하는 효과를 준다.

w1 = [[-1.0,1.0],[-1.0,1.0]] # 경계를 찾기 좋아보이는 필터이다. (엣지검출)

w=np.concatenate([np.array(w0).reshape(2,2,1,1),np.array(w1).reshape(2,2,1,1)],axis=-1)

w

b= np.array([0.0,0.0])

b

conv.set_weights([w,b])

conv.get_weights()

- 첫번째는 평균을 구하는 필터,

- 두번째는 엣지를 검출하는 필터

- 필터를 넣은 결과를 확인

XXX0=conv(XXX)[...,0] # 채널0

XXX0

XXX1=conv(XXX)[...,1] # 채널1

XXX1

- 각 채널을 시각화

fig, ((ax1,ax2),(ax3,ax4)) = plt.subplots(2,2)

ax1.imshow(XXX.reshape(50,50),cmap='gray')

ax3.imshow(XXX0.reshape(49,49),cmap='gray')

ax4.imshow(XXX1.reshape(49,49),cmap='gray')

fig

- 2사분면: 원래이미지

- 3사분면: 원래이미지 -> 평균을 의미하는 conv적용

- 4사분면: 원래이미지 -> 엣지를 검출하는 conv적용

- conv(XXX)의 각 채널에 한번더 conv를 통과시켜보자

conv(XXX0.reshape(1,49,49,1))[...,0] ### XXX0 -> 평균필터 <=> XXX -> 평균필터 -> 평균필터

conv(XXX0.reshape(1,49,49,1))[...,1] ### XXX0 -> 엣지필터 <=> XXX -> 평균필터 -> 엣지필터

conv(XXX1.reshape(1,49,49,1))[...,0] ### XXX1 -> 평균필터 <=> XXX -> 엣지필터 -> 평균필터

conv(XXX1.reshape(1,49,49,1))[...,1] ### XXX1 -> 엣지필터 <=> XXX -> 엣지필터 -> 엣지필터

fig,ax =plt.subplots(3,4)

ax[0][0].imshow(XXX.reshape(50,50),cmap='gray') # 원래이미지

ax[1][0].imshow(XXX0.reshape(49,49),cmap='gray') # 원래이미지 -> 평균필터

ax[1][2].imshow(XXX1.reshape(49,49),cmap='gray') # 원래이미지 -> 엣지필터

ax[2][0].imshow(conv(XXX0.reshape(1,49,49,1))[...,0].reshape(48,48),cmap='gray') # 원래이미지 -> 평균필터

ax[2][1].imshow(conv(XXX0.reshape(1,49,49,1))[...,1].reshape(48,48),cmap='gray') # 원래이미지 -> 엣지필터

ax[2][2].imshow(conv(XXX1.reshape(1,49,49,1))[...,0].reshape(48,48),cmap='gray') # 원래이미지 -> 평균필터

ax[2][3].imshow(conv(XXX1.reshape(1,49,49,1))[...,1].reshape(48,48),cmap='gray') # 원래이미지 -> 엣지필터

fig.set_figheight(8)

fig.set_figwidth(16)

fig.tight_layout()

fig

- 요약

- conv의 weight에 따라서 엣지를 검출하는 필터가 만들어지기도 하고 스무딩의 역할을 하는 필터가 만들어지기도 한다. 그리고 우리는 의미를 알 수 없지만 어떠한 역할을 하는 필터가 만들어질 것이다.

- 이것들을 조합하다보면 우연히 이미지를 분류하기에 유리한 특징을 뽑아내는 weight가 맞춰질 수도 있겠다.

- 채널수를 많이 만들고 다양한 웨이트조합을 실험하다보면 보다 복잡한 이미지의 특징을 추출할 수도 있을 것이다?

- 컨볼루션 레이어의 역할 = 이미지의 특징을 추출하는 역할

- 참고: 스트라이드, 패딩

- 스트라이드: 윈도우가 1칸씩 이동하는 것이 아니라 2~3칸씩 이동함

- 패딩: 이미지의 가장자리에 정당한 값을 넣어서 (예를들어 0) 컨볼루션을 수행. 따라서 컨볼루션 연산 이후에도 이미지의 크기가 줄어들지 않도록 방지한다.

- 기본적역할: 이미지의 크기를 줄이는 것

- 이미지의의 크기를 줄여야하는 이유? 어차피 최종적으로 10차원으로 줄어야하므로

- 이미지의 크기를 줄이면서도 동시에 아주 크리티컬한 특징은 손실없이 유지하고 싶다~

- 점점 작은 이미지가 되면서 중요한 특징들은 살아남지만 그렇지 않으면 죽는다. (캐리커쳐 느낌)

- 평균이 아니라 max를 쓴 이유는? 그냥 평균보다 나을것이라고 생각했음..

- 그런데 사실은 꼭 그렇지만은 않아서 최근에는 꼭 맥스풀링을 고집하진 않는 추세 (평균풀링도 많이씀)

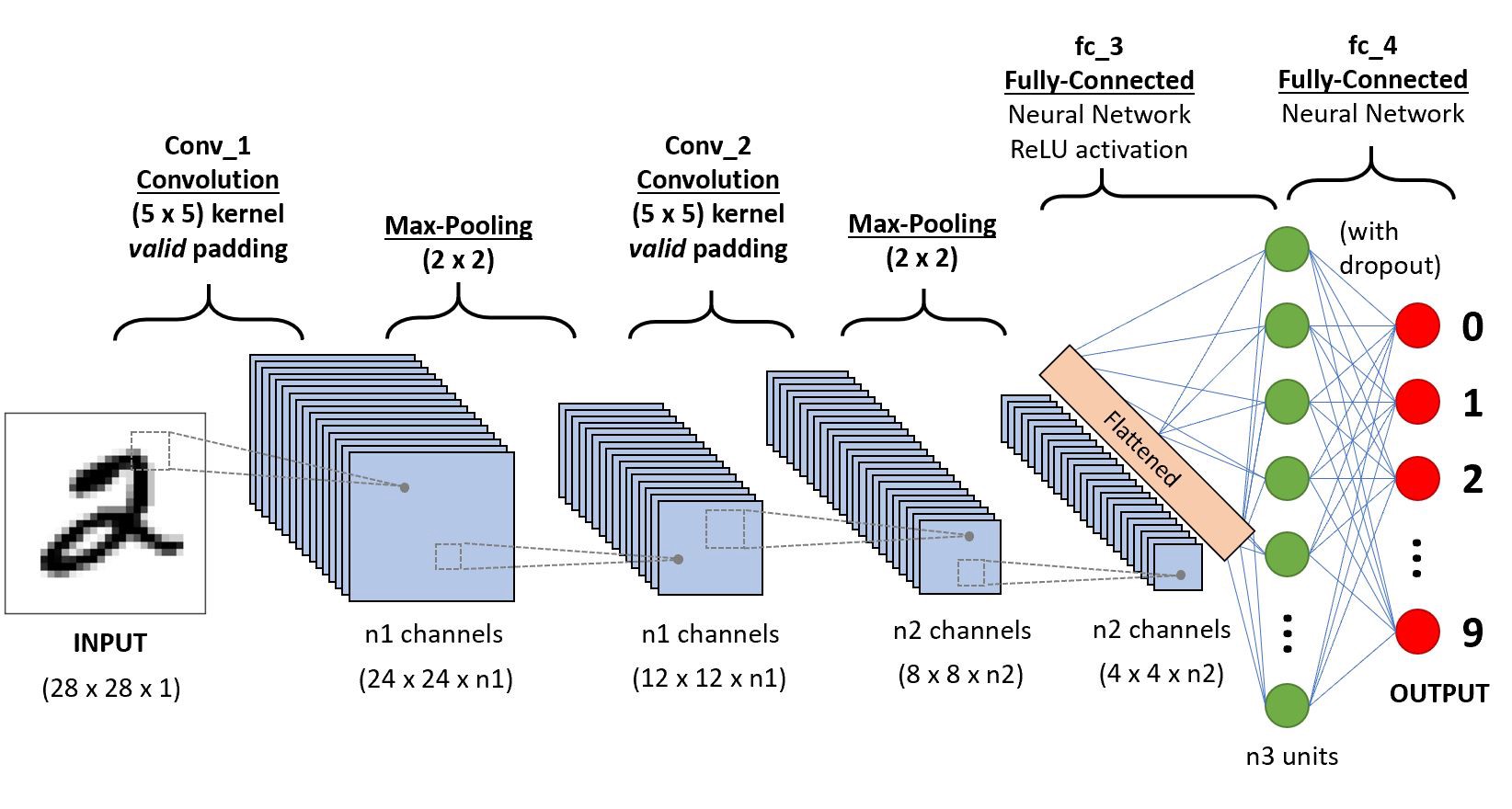

- 아래와 같이 아키텍처의 다이어그램형태로 표현하고 굳이 노드별로 이미지를 그리진 않음

- 물론 아래와 같이 그리는 경우도 있음

- 격자형태로 배열된 자료를 처리하는데 특화된 신경망이다.

- 시계열 (1차원격자), 이미지 (2차원격자)

- 실제응용에서 엄청난 성공을 거두었다.

- 이름의 유래는 컨볼루션이라는 수학적 연산을 사용했기 때문

- 컨볼루션은 조금 특별한 선형변환이다.

- 신경과학의 원리가 심층학습에 영향을 미친 사례이다.

- 희소성 + 매개변수의 공유

- 다소 철학적인 모티브임

- 희소성: 이미지를 분석하여 특징을 뽑아낼때 부분부분의 특징만 뽑으면 된다는 의미

- 매개변수의 공유: 한 채널에는 하나의 역할을 하는 커널을 설계하면 된다는 의미 (스무딩이든 엣징이든). 즉 어떤지역은 스무딩, 어떤지역은 엣징을 할 필요가 없이 한채널에서는 엣징만, 다른채널에서는 스무딩만 수행한뒤 여러채널을 조합해서 이해하면 된다.

- 매개변수 공유효과로 인해서 파라메터가 확 줄어든다.

(예시) (1,6,6,1) -> (1,5,5,2)

- MLP방식이면 (36,50) 의 차원을 가진 매트릭스가 필요함 => 1800개의 매개변수 필요

- CNN은 8개의 매개변수 필요

- 기본유닛

- conv - activation - pooling

- conv - conv - activation - pooling

- 아래와 같은 이미지의 edge를 찾아내는 (2,2) conv 필터를 설계하라. (코드구현없이 답만써도 무방)

plt.imshow(XXX.reshape(50,50).T,cmap='gray')